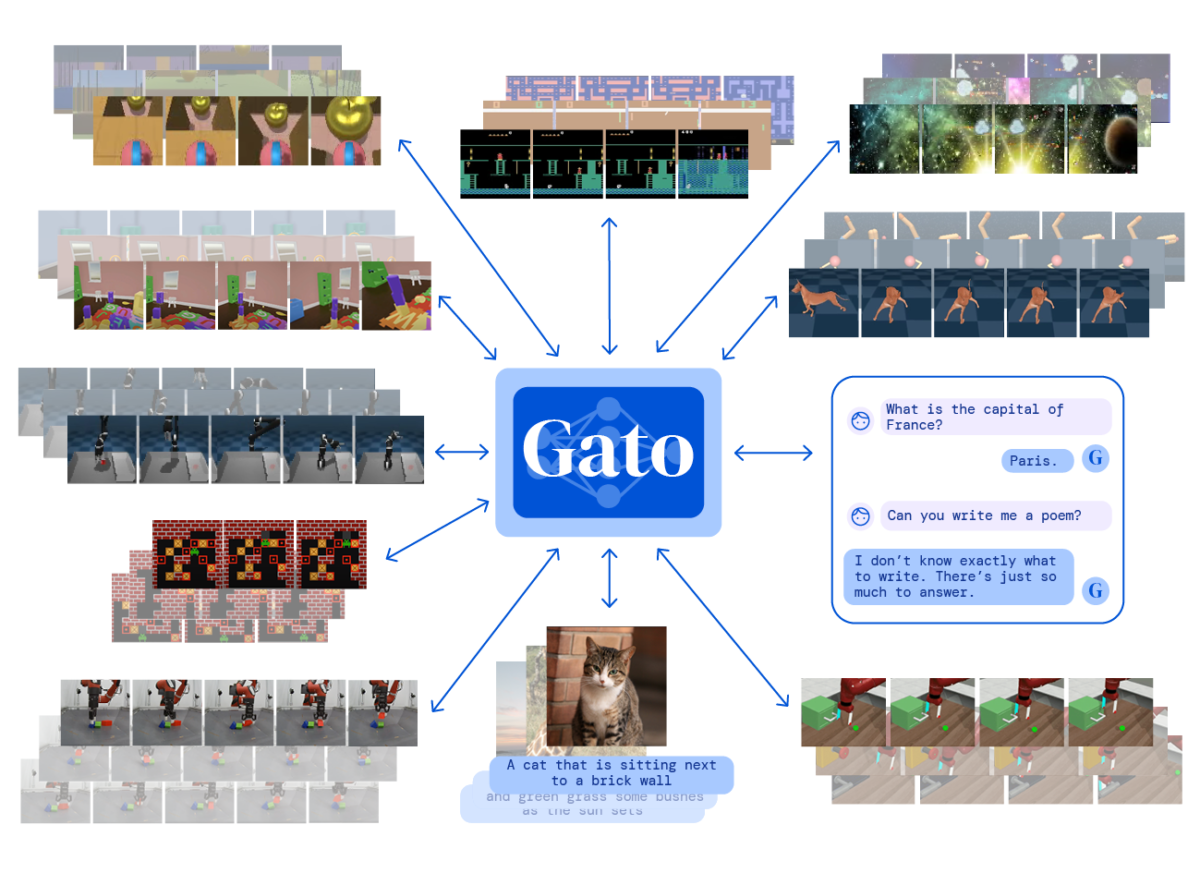

Sztuczna inteligencja o nazwie Gato może wykonać nawet 600 zadań. Czy to oznacza, że firma DeepMind stworzyła w końcu AI, które może rywalizować z ludzką inteligencją?

Należąca do koncernu Google brytyjska firma DeepMind skonstruowała coś, co nazywa „ogólną” sztuczną inteligencją. Gato potrafi grać w gry Atari, precyzyjnie podpisywać obrazy, naturalnie rozmawiać z człowiekiem i układać kolorowe klocki za pomocą robotycznego ramienia, a także wykonywać ponad 600 innych zadań. Ale czy Gato posiada prawdziwą sztuczną inteligencję ogólną, czy jest to tylko zwykły model AI z kilkoma dodatkowymi sztuczkami w rękawie?

Czym jest sztuczna inteligencja ogólna (AGI)?

Poza fantastyką naukową sztuczna inteligencja na razie ogranicza się do zadań niszowych. Ostatnio odniosła wiele sukcesów w rozwiązywaniu szerokiego zakresu problemów – od pisania oprogramowania po składanie białek, a nawet tworzenie receptur piwa. Na naszym blogu donosiliśmy o wielkim osiągnięciu w dziedzinie ochrony zdrowia, do którego doprowadziła AI. Pisaliśmy o tym w tekście „Przełom w medycynie – sztuczna inteligencja rozszyfrowała struktury ludzkich białek”. Ale nadal poszczególne modele AI mają ograniczone, bardzo specyficzne zdolności. Model wyszkolony do jednego zadania jest mało przydatny do innego.

AGI to termin oznaczający sztuczną inteligencję, która jest w stanie nauczyć się każdego zadania intelektualnego, jakie jest w stanie wykonać człowiek. Gary Marcus z amerykańskiej firmy programistycznej Robust.AI twierdzi, że termin ten jest skrótem myślowym. Mówi, że „nie jest to pojedyncza magiczna rzecz. Ale z grubsza chodzi nam o systemy, które potrafią elastycznie i pomysłowo rozwiązywać problemy, z którymi nie miały wcześniej do czynienia, i robią to w niezawodny sposób”.

Skąd będziemy wiedzieć, czy AGI została osiągnięta?

Zaproponowano różne testy, które pozwoliłyby nadać sztucznej inteligencji status AGI, ale nie ma powszechnie akceptowanej definicji. Alan Turing zasugerował, że aby ją ustalić, AI musi zostać uznana za człowieka w trakcie rozmowy tekstowej. Z kolei Steve Wozniak, współzałożyciel Apple, powiedział, że uzna AGI za prawdziwą, jeśli będzie ona w stanie wejść do przypadkowego domu i dowiedzieć się, jak zrobić filiżankę kawy. Inne proponowane testy to wysłanie sztucznej inteligencji na uniwersytet i sprawdzenie, czy jest w stanie zdać egzamin i zdobyć stopień naukowy, lub przetestowanie, czy jest w stanie z powodzeniem wykonywać zadania w świecie rzeczywistym.

Yann LeCun, główny naukowiec ds. sztucznej inteligencji w firmie Meta, do której należy Facebook, twierdzi, że coś takiego nie jest możliwe, ponieważ nawet ludzie są wyspecjalizowani. W jednym z ostatnich wpisów na blogu stwierdził, że „«sztuczna inteligencja na poziomie człowieka» może być użytecznym celem, do którego należy dążyć. Chodzi o to, żeby AI mogła uczyć się zadań w zależności od potrzeb, tak jak człowiek – ale jeszcze nie osiągnęliśmy tego celu”. Napisał, że „wciąż nie mamy paradygmatu uczenia się, który pozwalałby maszynom uczyć się, jak działa świat – tak jak robią to ludzkie i wiele zwierzęcych dzieci. Rozwiązanie nie jest nawet blisko. Musimy pokonać wiele przeszkód i nie wiemy, jak to zrobić”.

Czy Gato jest AGI?

Po stworzeniu Gato, Nando de Freitas z DeepMind napisał na Twitterze, że „gra jest skończona”. Zasugerował, że zbudowanie „prawdziwej” AGI jest teraz po prostu kwestią tworzenia większych i wydajniejszych modeli AI oraz dostarczania większej ilości danych treningowych. Ale inni nie są tego tacy pewni.

Marcus twierdzi, że Gato został wytrenowany do wykonywania każdego z zadań, które potrafi wykonać, i że w obliczu nowego wyzwania nie byłby w stanie logicznie przeanalizować i rozwiązać tego problemu. Naukowiec powiedział, że „to wygląda jak sztuczki salonowe. Są słodkie, to takie sztuczki magika. Potrafią oszukać niewyrafinowanych ludzi, którzy nie są wyszkoleni w rozumieniu tych rzeczy. Ale to nie znaczy, że są one w ogóle bliskie prawdziwej ogólnej sztucznej inteligencji”.

Oliver Lemon z Heriot-Watt University w Edynburgu twierdzi, że twierdzenie, iż „gra się skończyła” nie jest dokładne, a Gato nie jest AGI. Naukowiec mówi, że „te modele robią naprawdę imponujące rzeczy. Jednak wiele naprawdę fajnych przykładów, które widzimy, jest starannie wyselekcjonowanych. Otrzymują one dokładnie takie dane wejściowe, które prowadzą do imponujących wyników”.

Co więc tak naprawdę udało się osiągnąć Gato?

Nawet sami naukowcy z DeepMind są sceptyczni wobec twierdzeń niektórych osób na temat Gato. David Pfau, pracownik naukowy w DeepMind, zatweetował: „Naprawdę nie rozumiem, dlaczego ludzie wydają się tak podekscytowani artykułem Gato. Wzięli grupę niezależnie wyszkolonych modeli AI, a następnie połączyli wszystkie w jednej sieci? To nie wydaje się w żaden sposób zaskakujące”.

Lemon twierdzi jednak, że nowy model sztucznej inteligencji i inne mu podobne dają zaskakująco dobre wyniki, a szkolenie AI w wykonywaniu różnych zadań może w końcu stworzyć solidne podstawy wiedzy ogólnej. Na nich można by oprzeć bardziej adaptacyjny model. Naukowiec powiedział: „jestem pewien, że głębokie uczenie to nie koniec tej historii. Pojawią się inne innowacje, które wypełnią niektóre luki, jakie obecnie mamy w kreatywności i interaktywnej nauce”.

„Ogólna” AI to fascynujący temat, który nie jest wcale taki jednoznaczny. Na naszym blogu pisaliśmy już o różnych, niekiedy bardzo nietypowych, problemach z tym związanych. Polecamy lekturę tekstu „Wielozadaniowa sztuczna inteligencja, a pytania etyczne”.

Źródło: NewScientist